華南理工大學金連文教授團隊在CVPR16 VIVA競賽中獲得多項第一

文章來源: | 發布時間:2016-10-20 | 【打印】 【關閉】

在國家重點研發計劃“云端融合的自然交互設備和工具”的支持下,在剛剛結束的2016年CVPR會議的VIVA(智能駕駛及應用)手部檢測及分類挑戰賽中,本項目課題5華南理工大學金連文教授團隊在手部檢測和手部分類兩項任務中取得多項技術指標第一名。

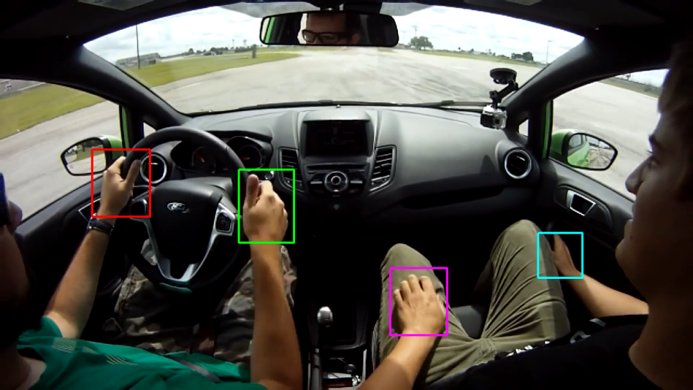

VIVA是基于視覺系統的智能駕駛及應用的挑戰賽,今年是第二屆比賽。VIVA手部競賽有兩個任務,一個是從駕駛室中拍攝的彩色圖像中檢測出手部位置,另一個是對手部進行分類,識別出駕駛員和乘客手,以及左手和右手。這些圖像在駕駛員實際駕駛的過程中拍攝,攝像頭放置在駕駛員的肩膀后面或者駕駛室儀表盤位置,具體拍攝角度差異較大。圖像庫包含比較大的光照、角度、姿態、手部膚色和遮擋等變化和因素影響,尤其是不同視角左右手的識別,具有相當的挑戰性。今年的比賽吸引了包括卡耐基梅隆大學(CMU),普渡大學 (Purdue University),加州大學圣地亞哥分校 (UC San Diego),印第安納大學(Indiana University) 和華南理工大學(South China University of Technology, SCUT)等多個知名高校參加。

圖1. CVPR HANDS detection Challenge 2016 獲獎證書及華南理工大學研究生黃毅超上臺領獎

圖2. VIVA Challenge 手部檢測及分類任務 (from http://cvrr.ucsd.edu/vivachallenge/index.php/hands)

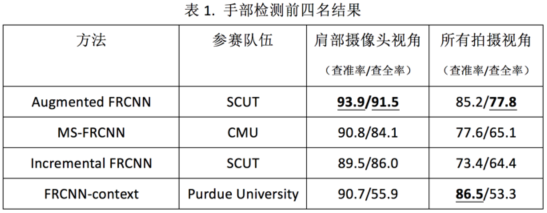

針對手部檢測問題,華南理工大學團隊提出了Augmented Faster R-CNN,在多次訓練過程中采用隨機組合訓練數據,隨機丟棄訓練數據標記的策略,以達到正則化和減少過擬合的效果。在肩部攝像頭視角數據庫中,取得93.5%/91.5% (查準率/查全率),分別比第二名(來自CMU)高3.1及7.4;在所有拍攝視角數據庫中,取得85.2%/77.8%的結果。上述四項指標中有三項指標獲得第一。

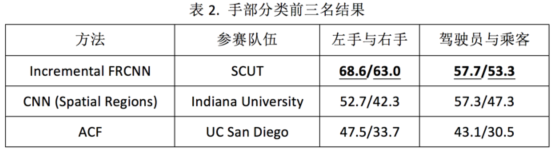

針對手部分類問題,華南理工大學團隊提出了Incremental Faster R-CNN算法,利用間隔未標注數據與標注數據一起進行半監督增強學習,在左手與右手分類任務中識別率為68.6%和63.0%,分別比第二名(來自Indiana University)高15.9和20.7;在駕駛員和乘客手部分類任務中識別率為57.7%和53.3%。上述四項指標均位列第一。